di Sergio Mauri

Il Machine Learning si basa su una serie di principi, postulati e modelli matematici che ne costituiscono le fondamenta. Di seguito ti elenco alcuni dei concetti matematici chiave utilizzati nel Machine Learning:

- Postulato dell’apprendimento: Il postulato fondamentale del Machine Learning afferma che esiste una relazione tra i dati di input e gli output corrispondenti, e che tale relazione può essere appresa dai dati attraverso un processo di addestramento.

- Funzioni di ipotesi: Nell’ambito del Machine Learning, le funzioni di ipotesi sono modelli matematici che approssimano la relazione tra i dati di input e gli output. Queste funzioni vengono apprese durante la fase di addestramento e vengono utilizzate per fare previsioni o prendere decisioni sui nuovi dati.

- Algoritmi di ottimizzazione: Gli algoritmi di ottimizzazione sono utilizzati per regolare i parametri interni delle funzioni di ipotesi al fine di minimizzare l’errore o massimizzare una misura di prestazione specifica. Questo processo, noto come addestramento del modello, consiste nel cercare i migliori valori dei parametri che consentono al modello di fare previsioni accurate.

- Regressione lineare: La regressione lineare è un modello matematico utilizzato per modellare la relazione tra una variabile di output continua e una o più variabili di input. L’obiettivo è trovare la migliore linea retta che si adatta ai dati di addestramento, in modo da poter fare previsioni sulla variabile di output per nuovi dati di input.

- Classificazione: La classificazione è un problema comune nel Machine Learning, in cui l’obiettivo è assegnare a ciascun esempio di input una classe o una categoria predefinita. Ci sono diversi modelli matematici utilizzati per la classificazione, tra cui il classificatore lineare, gli alberi decisionali, le reti neurali e i support vector machine (SVM).

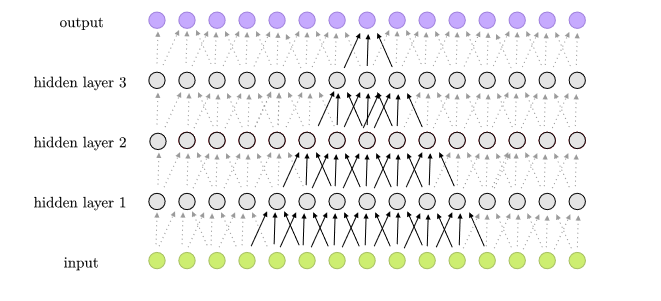

- Reti neurali artificiali: Le reti neurali artificiali sono modelli matematici ispirati al funzionamento del cervello umano. Questi modelli sono composti da unità di calcolo chiamate neuroni artificiali, organizzati in strati e collegati tra loro da pesi. Le reti neurali sono ampiamente utilizzate nel Machine Learning per risolvere problemi complessi come il riconoscimento delle immagini, il trattamento del linguaggio naturale e il controllo dei robot.

- Teoria della probabilità: La teoria della probabilità è un concetto fondamentale nel Machine Learning. Viene utilizzata per modellare l’incertezza e calcolare la probabilità di eventi futuri. Le distribuzioni di probabilità, i teoremi di Bayes e gli algoritmi di inferenza statistica sono strumenti utilizzati per gestire l’incertezza e fare previsioni basate su dati di addestramento.

Questi sono solo alcuni dei principali concetti matematici utilizzati nel Machine Learning. Ci sono molti altri modelli, teoremi e algoritmi specifici che vengono utilizzati nel campo del Machine Learning. Alcuni esempi includono:

- Alberi decisionali: Gli alberi decisionali sono modelli che rappresentano una serie di decisioni in un formato ad albero. Ogni nodo rappresenta una decisione o una caratteristica, e i rami rappresentano le possibili conseguenze delle decisioni. Gli alberi decisionali vengono utilizzati per problemi di classificazione e regressione.

- Support Vector Machine (SVM): Le SVM sono un modello di apprendimento supervisionato utilizzato per la classificazione e la regressione. Questo modello identifica un iperpiano ottimale che separa le classi nel miglior modo possibile nello spazio delle caratteristiche.

- Reti neurali convoluzionali (CNN): Le CNN sono un tipo di rete neurale utilizzato principalmente per il riconoscimento delle immagini e la visione artificiale. Questi modelli sfruttano l’architettura convoluzionale, che consente di identificare automaticamente pattern e caratteristiche nelle immagini.

- Processi decisionali di Markov (MDP): I MDP sono un framework matematico utilizzato nel campo del reinforcement learning, in cui un agente apprende ad agire in un ambiente per massimizzare una ricompensa. I MDP modellano le decisioni sequenziali in cui lo stato attuale dipende dalle azioni precedenti.

- Analisi dei componenti principali (PCA): La PCA è una tecnica utilizzata per ridurre la dimensione dei dati mantenendo le informazioni più rilevanti. Questa tecnica identifica le componenti principali dei dati e proietta gli esempi in uno spazio a dimensione ridotta.

- Insiemi fuzzy: Gli insiemi fuzzy consentono di gestire l’incertezza e la sfumatura nelle decisioni. Questi insiemi assegnano gradi di appartenenza ai valori, consentendo una rappresentazione più flessibile delle relazioni tra i dati.

Questi sono solo alcuni degli approcci, dei teoremi e dei modelli matematici utilizzati nel campo del Machine Learning. Il campo è in continua evoluzione e nuovi sviluppi e tecniche vengono introdotti regolarmente per affrontare problemi sempre più complessi e migliorare le prestazioni dei modelli.